Den amerikanske professor og statistiker, William Edwards Deming, bliver stadig citeret for at sige ‘In God we trust. All others bring data’.

Et citat, der efter hans død i 1993 fortsat er spot on den måde vi arbejder på i dag.

Vi indsamler, analyserer og fortolker data med henblik på at forbedre performance. Det gælder både, når der trænes op til maraton eller på vores arbejde, når vi skal forstå performance og sikre at vi får mest muligt ud den trafik vi får til vores websites. Vi bruger data alle steder og til alle mulige ting.

Men kan vi stole på vores data? Hvilke minimumskrav har vi til vores datakvalitet, og husker vi at få italesat og sikret vores data kvalitet løbende?

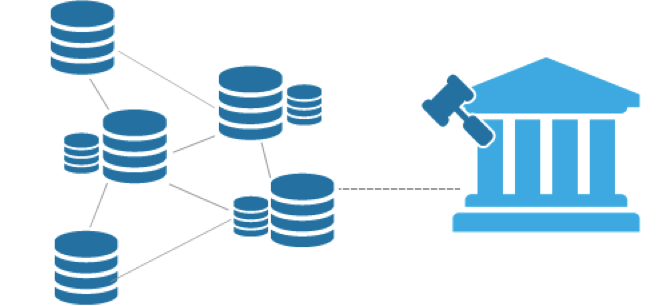

I de fleste organisationer, ligger digital analyse som et selvstændigt område, eller som en del af hhv. marketing eller eCommerce. Men ser vi på andre steder i organisationen, hvor data er i højsædet, så er data governance en helt naturlig del af dialogen og de processer der er. Se bare på jeres økonomi eller BI afdeling.

De har styr på datakvaliteten og man hører aldrig nogle stille spørgsmål ved kvaliteten af deres data, uden at de respektive afdelinger kan svare for sig, og dokumenterer at der dels er styr på kvaliteten af data.

Os der arbejder med digital analyse, bør lære noget af vores kollegaer i de andre afdelinger. Vi bør sikre at data governancen kommer på agendaen og budgettet, for det er ikke helt gratis.

Datakvalitet skal diskuteres før der opstår et problem

Der er typisk 2 scenarier, hvor dialogen om datakvalitet kommer op. Den første er i forbindelse med re-lancering af hele eller dele af et website eller ved skift/implementering af en analyse platform.

Der er typisk 2 scenarier, hvor dialogen om datakvalitet kommer op. Den første er i forbindelse med re-lancering af hele eller dele af et website eller ved skift/implementering af en analyse platform.Det andet scenarie er, når nogle stiller spørgsmålstegn ved resultatet af en analyse.

De fleste der arbejde med digital analyse har fået spørgsmål ’er du nu helt sikker på, at data er rigtig?’, og de fleste kan næppe svare helt oprindeligt, at det er de. Og hvad nytter det, at man i den aktuelle dialog ser på hvordan ens dataopsamling virker lige nu her, når det typisk er data som er indsamlet tidligere, der stilles spørgsmålstegn ved?

Når først nogle har stillet spørgsmålstegn ved kvaliteten af dine data, er det utrolig svært at genvinde deres tillid til dine data, også selvom deres mistillid måske slet ikke har været begrundet.

At få sat datakvalitet i struktur er vitalt. Det både gavner tilliden til de findings og anbefalinger du udarbejder, men det gør også at du kan bruge din og dit teams tid på netop at udarbejde insights og anbefalinger, frem for at diskuterer hvorvidt frafaldet mellem 2 step nu også var 37% eller ej…

Hvor skal man starte?

Sikring af datakvaliteten, er et fælles arbejde mellem flere dele af en organisation. Det er ikke nok, at man kun tester sin data når man laver strukturelle ændringer af sin implementering. Det er heller ikke nok, at man kun tester sin data opsamling når man foretager rettelser på websitet der har direkte indflydelse på sin analytics implementering. Man skal teste sin implementering ved hver release man foretager sig, eller risikerer man at ens data påvirkes uden man er opmærksom på det. Og når man så finder ud af det, har man måske dages, ugers eller måneders data som er fejlbehæftede.

Vi har set mange eksempler på, at der foretages ændringer på et website der utilsigtet har indflydelse på ens analytics data. Ofte fanges disse ikke, da de fleste virksomheder ikke køre en fuld test af analytics data opsamling, når man ændre ting der ’ikke har noget med analytics at gøre’.

Problemet er bare, at de fleste ændringer man laver rent faktisk kan have en indirekte påvirkning af ens analytics data, hvorfor man altid skal lave en fuld test af sin analytics data opsamling. På samme måde, som andre tests altid udføres før man foretager en release.

Sikring af en korrekt data opsamling, indebærer altså at ens QA processer bliver opdateret til også at indeholde test af ens analytics implementering.

Ved at implementerer en model som sikre at analytics data valideres før hver release, sikre at der ikke den vej igennem rulles ændringer ud, der negativt påvirker vores data. Denne proces skal naturligvis også tage højde for releases af koder og tags, der sker via et Tag Management system.

Automatiseret tests er vejen frem

Når man taler om automatiseret tests, er der flere niveauer man skal teste på. Dels skal man sikre, at der rent faktisk bliver afsendt data fra websitet til analytics løsning. Det findes der utallige værktøjer som kan hjælpe med, men man bør ikke stopper her. Man bør sikre, at der ikke blot opsamles data, men også at det er den rette data og at data sendes ind i det rette format.

Der findes adskillige gode værktøjer på marked til at foretage løbende validering af tag implementering med, det mest kendte er nok ObservePoint der har været i marked i mange år, eller Hub’Scan. Begge meget avanceret løsninger, der vil kunne højne datakvaliteten hos de fleste. Løsninger der med tiden er kommet ned i et prisleje hvor de fleste kan være med, samtidig med at de har udviklet sig markant.

Der findes et hav af udfordre på marked, der gerne vil tage markedsandele fra både ObservePoint og Hub’Scan. Disse alternativer kommer i forskellige kvalitets- og pris niveauer.

Kom godt fra start

Uanset hvilke værktøj man vælger til at få styr på sine tags og datakvalitet, så bør man starte op simpelt. Data governancen er en tidskrævende proces og der findes ikke et plug-and-play tool, der både fortæller om du har de rigtige tags og hvorvidt data der sendes med dem ind er rigtig eller forkert.

Den del kræver opsætning af regler i dit tag governancen værktøj, for at det kan validerer om det der sker på sitet nu også er rigtigt eller forkert.

Man vil naturligvis opleve den største værdi, ved at have et Tag governancen tool der både sikre at de rigtige tags er tilstede samt at det er korrekt data de sender, men man kan sagtens starte mere enkelt. Bare at få skabt et overblik over de tags man har på sit site og hvor de ligger, er en rigitg god start. Her kan du hurtigt identificerer om der er steder på sitet du ikke opsamler data samt om der måske er steder hvor du har ’for mange tags’…

Når du har styr på om der eventuelt mangler eller er for mange tags deployet, og har fået ryddet op i den del, kan du gå til næste fase, nemlig at få lavet data-validering af de data som sendes ind.

Først her ved du realt hvor ren din data er. Dermed ikke sagt, at du ikke opnår markant værdi allerede tidligere i processen, for det gør du.

Ønsker du eller din virksomhed at lære mere om Tag og Data governance, kan du kontakte Andreas Petersson på +45 51 71 43 63 eller ap@ecapacity.dk